안녕하세요 쿤드입니다. 🍀

이번엔 EKS Cluster를 생성해 보겠습니다.

Amazon EKS

- Amazon EKS는 Kubernetes의 Control Plain or Node를 설치, 운영 및 유지보수 할 필요 없이 AWS에서 Kubernetes를 손쉽게 실행할 수 있는 관리형 서비스입니다.

- Kubernetes는 컨테이너화된 애플리케이션의 배포, 조정 및 관리 자동화를 위한 오픈 소스 시스템입니다.

구축하기

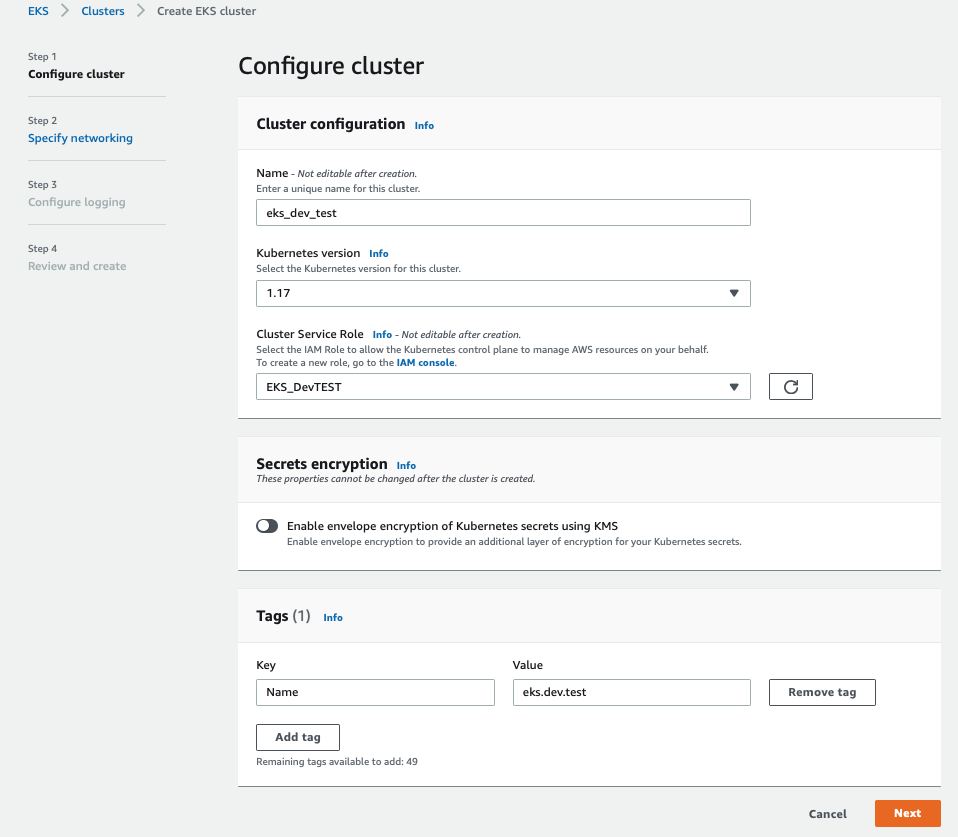

Step 1. 클러스터 설정 (Configure cluster)

- Name과 version을 선택합니다.

- Cluster Service로 사용할 IAM role을 미리 생성해두고 선택합니다.

- Tag는 적절하게 추가합니다. (나중에 관리 및 비용 구분하기 용이하도록)

Step 2. 네트워킹 설정 (Specify networking)

VPC(Virtual Private Cloud) 선택

- 원하는 VPC를 선택합니다.

- 필요한 경우 새로운 VPC를 생성합니다.

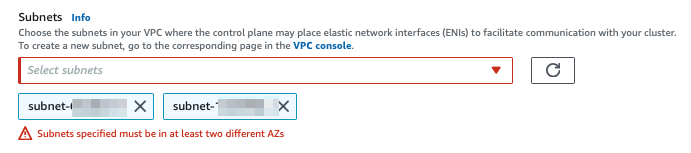

Subnet 선택

- EKS 클러스터를 생성할때는 2개 이상의 서브넷이 필요합니다.

- 물론 1개의 subnet에 public, private으로 구분할 수도 있는데 그렇게 2개 서브넷을 선택한 경우에는 이런 에러가 발생합니다.

- 노드를 위치시킬 VPC를 기존 사용하던 곳에 할지 완전히 분리하도록 새로운 VPC를 생성할지 결정한 후에 선택합니다.

- Endpoint Access 인 경우는 Private으로 설정하면 local pc에서 kubectl 설정하여 접근할때 아래의 문제로 인해서 추가적인 네트웍 설정이 필요합니다.

- Unable to connect to the server: dial tcp 172.xx.xxx.xx:443: i/o timeout

나머지는 로깅 할지 여부 설정, 그리고 review 이후에 생성하면 됩니다.

'Infra' 카테고리의 다른 글

| AWS VPC 생성하기 (455) | 2020.07.23 |

|---|---|

| AWS EKS Service Role 생성 (IAM) (454) | 2020.07.23 |

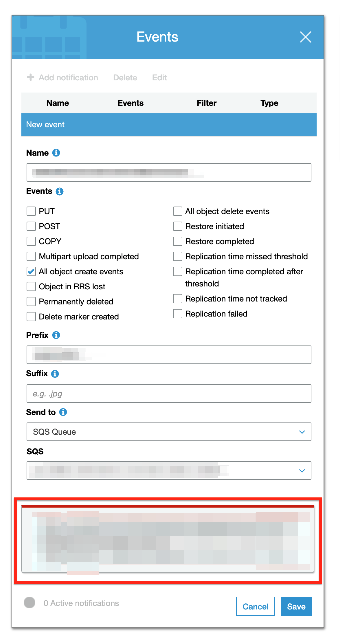

| S3에 SQS notification event 추가할때 권한 설정 (86) | 2020.06.26 |

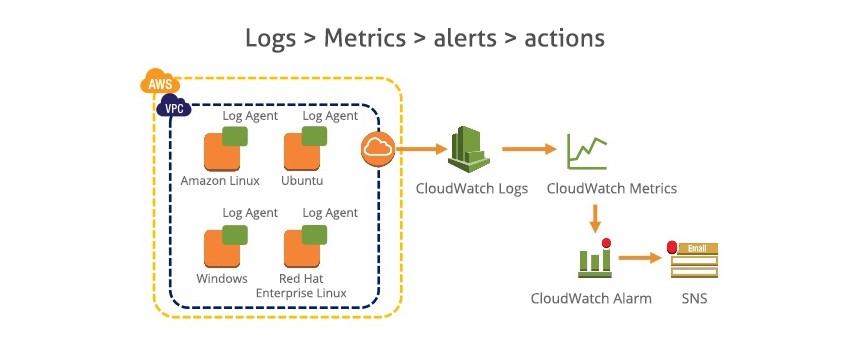

| AWS의 Cloudwatch와 CloudTrail의 차이 (14) | 2020.06.01 |

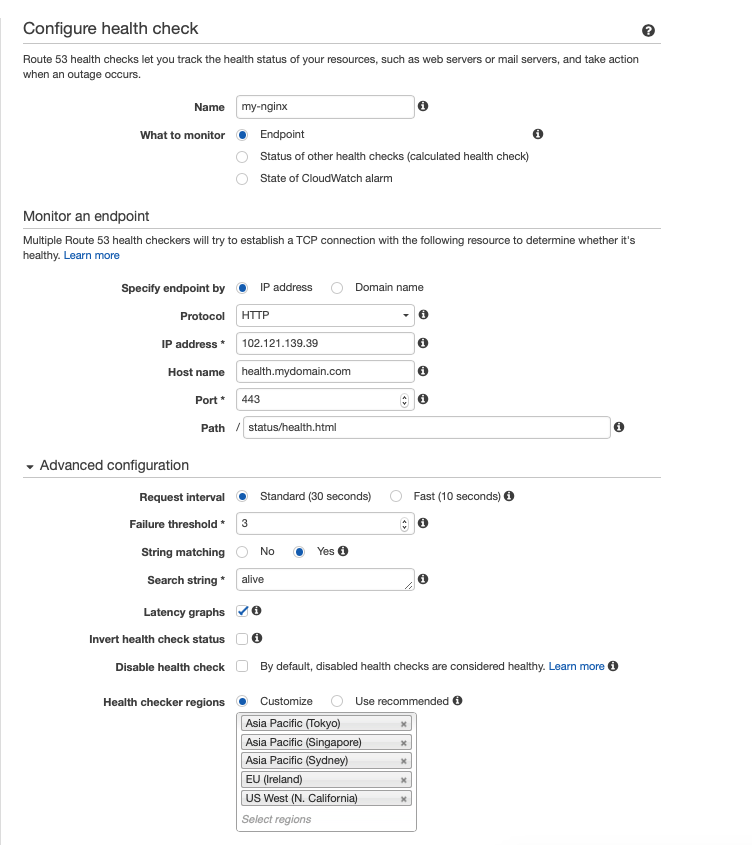

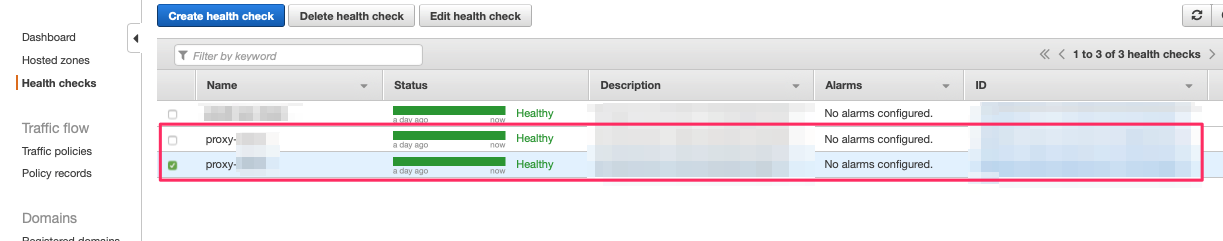

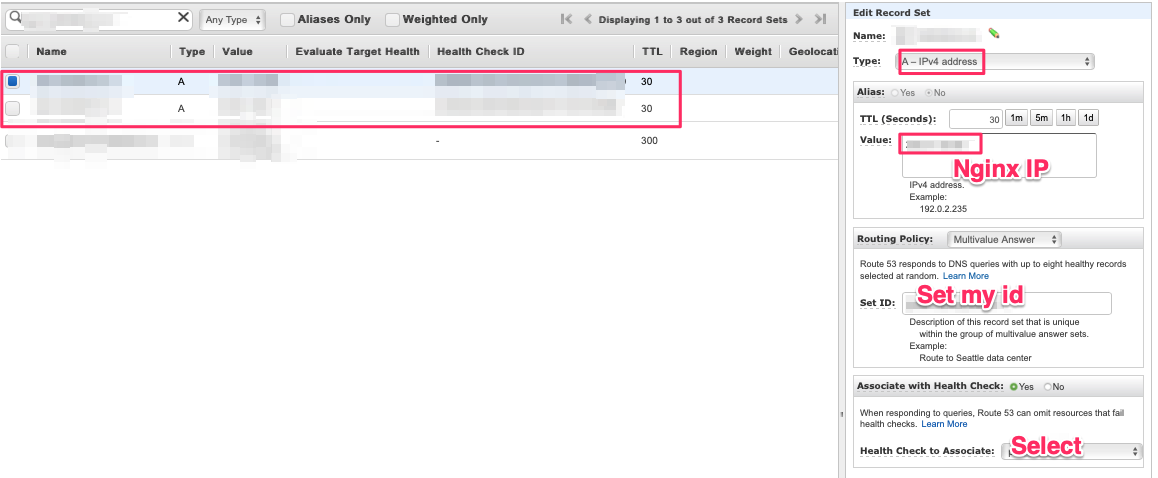

| Route53 DNS health check (for Nginx) (8) | 2019.12.20 |